Článek

Úvod

Umělá inteligence neúprosně vstupuje do života a mění ekonomiku i veřejnou správu.

Co je řízení a správa umělé inteligence (AI Governance), pravidla etiky a bezpečnosti?

Jak to vypadá v ČR s EU AI Act Compliance?

Proč je důležité porozumět i výkladu ne zcela v ČR lokalizovaného pojmu Governance AI?

Governance AI

Governance AI je kompasem civilizace – pomáhá nám nastavovat pravidla, aby umělá inteligence zůstala nástrojem lidství, nikoli jeho náhradou.

Bez pevného rámce správy AI riskujeme, že technologie přeroste své tvůrce a odvrátí se od základních hodnot, které formují humánní společnost.

Výklad klíčových pojmů:

„AI potřebuje pravidla – ne kvůli svým limitům, ale kvůli ochraně našich hodnot.“

🔎 „Compliance“ - přímé ekvivalenty:

EU AI Act Compliance

- Soulad s předpisy

– nejčastější a nejpřesnější překlad v právním a správním kontextu

(např. „soulad s GDPR“, „soulad s AI Act“) - Dodržování pravidel

– obecnější, vhodné pro firemní kulturu a interní směrnice

(např. „program dodržování pravidel“) - Plnění povinností

– často používané při kontrolách, auditech nebo správním dozoru

(např. „plnění regulatorních povinností“)

🧭 Volnější výklad pojmu Compliance:

- Právní a etická odpovědnost

– zdůrazňuje širší rámec než jen zákony, vhodné pro osvětové texty - Zodpovědné řízení rizik

– moderní pojetí compliance v rámci governance - Správa souladu a etiky

– pro interní směrnice v neziskových nebo inovativních organizacích - Kultura odpovědnosti

– pro HR a leadership texty, kde jde o postoj a hodnoty

📘 Úvod do výkladu pojmu „Governance AI“

Governance (řízení a správa) AI - Komplexní schéma

Governance AI (řízení a správa umělé inteligence) označuje

- systémová pravidla,

- postupy,

- hodnoty

- a odpovědnosti, které slouží k

- řízení,

- kontrole

- a strategickému nasazení AI systémů.

📚 Doporučené české ekvivalenty:

- Správa a řízení umělé inteligence

- Strategické řízení AI systémů

- Dozor nad AI technologiemi

- Etické a právní rámce používání AI

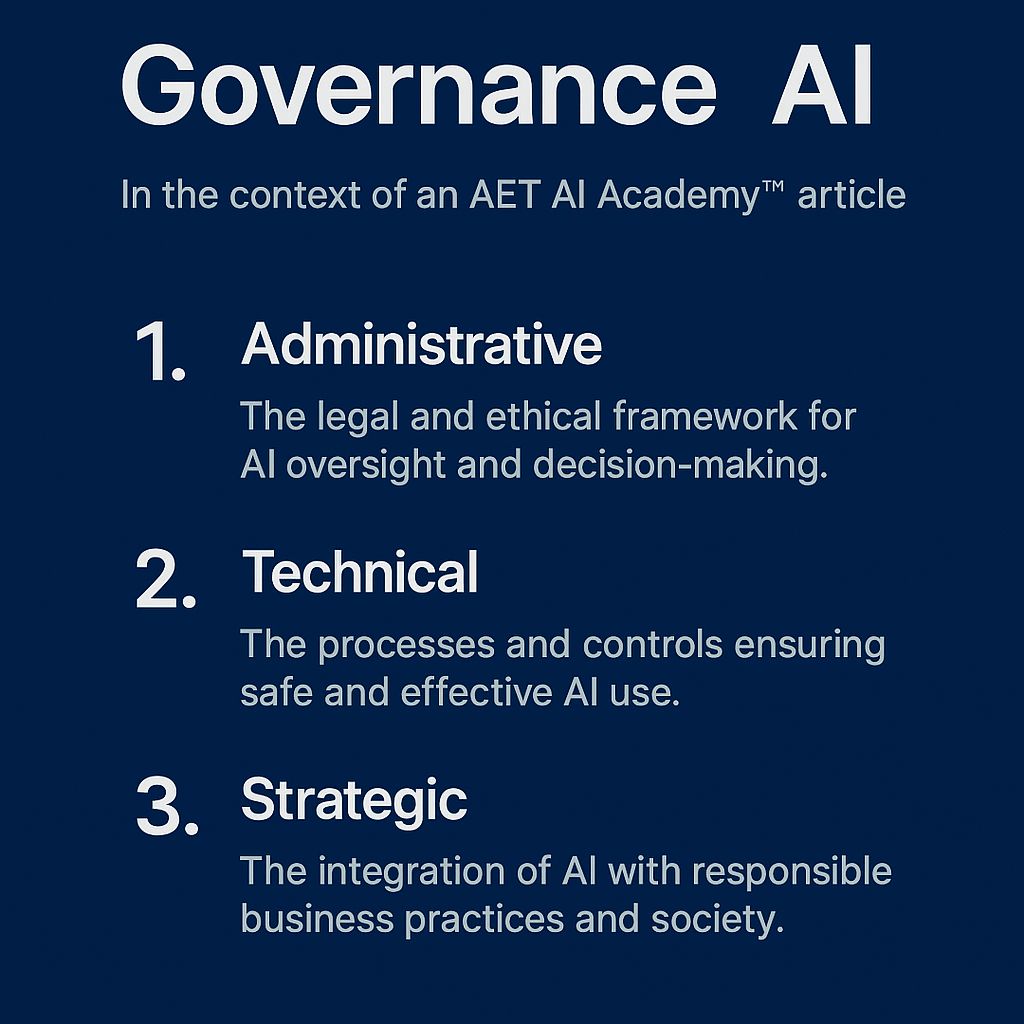

🔍 Tři pilíře AI Governance:

1. Administrativní (právní a etický rámec)

- Zahrnuje pravidla, standardy a odpovědnosti za dohled nad AI.

- Řeší právní soulad (např. s AI Act), etiku, odpovědnost a auditní stopu.

- Typické nástroje: směrnice, kodexy chování, etické komise.

2. Technický (systémový dohled)

- Zabývá se tím, jak bezpečně a účinně AI funguje.

- Patří sem validace modelů, datová kvalita, ochrana soukromí, kybernetická bezpečnost.

- Cílem je minimalizovat rizika a zajistit „AI safety“.

3. Strategický (dlouhodobé směřování a společenský přínos)

- Zaměřuje se na sladění AI s cíli organizace a společenskými hodnotami.

- Podporuje důvěru veřejnosti, inovace a odpovědný rozvoj.

- Klíčové principy: férovost, udržitelnost, transparentnost, přístupnost.

Tento článek nabízí aktuální přehled, důležité milníky a konkrétní doporučení.

Současně rekapituluje související právní rámec EU pro rok 2025 a očekávaný vývoj.

Průnik AI s DNA (bioetický AI Governance)

Umělá inteligence musí být vždy ve službě člověka a lidské důstojnosti. Technologie nesmí nikdy nahradit lidské svědomí a etickou zodpovědnost.

— papež František, mezinárodní konference o etice AI, Vatikán 2023, 2024

AET AI Act

Evropský AI Act: Nový standard pro celý svět?

Evropský akt o umělé inteligenci (AI Act), který vstoupil v platnost 1. srpna 2024,

je první komplexní regulací AI na světě.

Podobně jako v roce 2018 změnilo GDPR přístup k ochraně osobních údajů,

má AI Act ambici stát se globální normou pro vývoj a nasazení AI technologií.

Proč se mu přezdívá „nové GDPR“ pro AI?

- Stanovuje právně závazná pravidla pro systémy AI na základě rizika.

- Platí i pro firmy mimo EU, pokud jejich AI pracuje s daty občanů EU.

- Podporuje etiku, transparentnost, lidský dohled a odpovědnost.

- Vytváří precedent, který může ovlivnit legislativu po celém světě.

Klíčové milníky a harmonogram AI Act

- 12. 7. 2024 – zveřejnění v Úředním věstníku EU

- 1. 8. 2024 – vstup AI Act v platnost

- 2. 2. 2025 – zákaz systémů s nepřijatelným rizikem

- 2. 8. 2026 – účinnost většiny ustanovení (vysoké riziko, GenAI).

Kategorizace rizika AI systémů

Rizika

1. Zanedbatelné a nízké riziko

- Příklady: chatboti, doporučovací algoritmy.

- Požadavky: označení AI, kontakt na odpovědnou osobu.

2. Vysoké riziko

- Příklady: diagnostika, nábor, úvěrové hodnocení,

ale i využití AI ve vzdělávání viz rozbor níže.

- Požadavky: CE značka, auditovatelnost, lidský dohled.

POZOR! JE NEZBYTNÉ BÝT SPECIFICKÝ. V NĚKTERÝCH PŘÍPADECH JE TŘEBA ROZBOR!

Podle evropského nařízení o umělé inteligenci (AI Act) jsou některé aplikace AI ve vzdělávání klasifikovány jako „vysoce rizikové“ (high-risk).

Tato klasifikace vychází z Přílohy III AI Actu, která zahrnuje oblasti, kde může AI významně ovlivnit základní práva jednotlivců.

Vysoce rizikové aplikace AI ve vzdělávání

AI systémy ve vzdělávání jsou považovány za vysoce rizikové, pokud:

- rozhodují o přístupu k vzdělávacím příležitostem, například při přijímacích řízeních;

- hodnotí výsledky učení, například při automatickém známkování;

- monitorují a detekují zakázané chování studentů během testů.

Tyto systémy mohou zásadně ovlivnit vzdělávací a profesní dráhu jednotlivce, a tím i jeho schopnost zajistit si obživu.

Výjimky z klasifikace jako vysoce rizikové

AI systémy ve vzdělávání nemusí být považovány za vysoce rizikové, pokud:

- provádějí pouze "úzké" běžné procedurální úkoly;

- zlepšují výsledky již dokončené lidské činnosti;

- detekují vzory rozhodování bez nahrazení lidského hodnocení;

- slouží k přípravě na hodnocení, aniž by samy ovlivňovaly rozhodnutí.

Doporučení pro organizace

Organizace využívající AI ve vzdělávání by měly:

- posoudit, zda jejich AI systémy spadají do kategorie vysoce rizikových;

- zajistit soulad s požadavky AI Actu, včetně transparentnosti, lidského dohledu a řízení rizik;

- dokumentovat hodnocení rizik a být připraveny na kontrolu ze strany příslušných orgánů.

Tímto způsobem mohou organizace minimalizovat právní rizika a zajistit etické a spravedlivé využívání AI ve vzdělávání.

3. Nepřijatelné riziko

- Příklady: sociální skórování, manipulativní AI, prediktivní policejní systémy.

- Stav: Zákaz od února 2025 (s výjimkami - například pro bezpečnostní složky).

Co musí a již měla AI Act dotčená organizace splnit?

- Prvotní inventarizace a zavedení systému kategorizace všech AI systémů

- Vytvoření technické dokumentace a záznamových mechanismů

- Zavedení lidského dohledu a vysvětlitelnosti

- Školení zaměstnanců v oblasti etiky, compliance a bezpečnosti

Profesionální checklist souladu s AI Act

- Inventarizace systémů

- Kategorizace rizika

- Dokumentace a auditovatelnost

- Transparentnost výstupů

- Kyberbezpečnost a reakce na incidenty

- Etická komise a posouzení dopadů

- Vzdělávání a zapojení vedení

Přínosy implementace AI

📊 Interaktivní grafická analýza AI v ČR a světě (otevřít odkazy na Grafy níže)

Predikované výsledky (MPO ČR):

- Růst HDP o 2,8 % během 5 let

- Úspora 42 mld. Kč ročně

- Snížení administrativní zátěže o 35 %

- Zkrácení doby úředních procesů o 65 %

- Vznik 18 500 nových IT pracovních míst

Index vyspělosti správy AI v ČR

(doporučujeme Umělá inteligence | MPO )

- Průměrná hodnota: 62/100.

- Nejlepší výsledky: zdravotnictví (74)

- Mezinárodní srovnání: vede Švédsko (82), ČR předstihuje USA v dostupnosti pro SME

Stav implementace v českých organizacích

- 15 % ve fázi přípravy

- 35 % má základní přehled

- 30 % má kontrolní mechanismy

- 15 % pokročilá úroveň řízení

- 5 % plně integrovaný systém

„Znepokojivé je, že téměř polovina organizací nemá základní kontrolní opatření.“

— Ing. M. Svoboda, NÚKIB

Kyberbezpečnost AI systémů

Nárůst AI-specifických incidentů o 168 % (2024–2025)

6 pilířů bezpečnosti:

- Ochrana modelu

- Bezpečnost dat

- Odolnost proti útokům

- Zabezpečení prostředí

- Bezpečný vývoj

- Reakce na incidenty.

Etika a odpovědnost

- Jen 27 % organizací má etickou komisi

- Jen 18 % provádí systematické etické posouzení

4 pilíře etické správy:

- Transparentnost a vysvětlitelnost

- Respekt k autonomii

- Nediskriminace a spravedlnost

- Odpovědnost a vědomý rekurz

„Etická dimenze není luxus, ale nutnost.“

— prof. J. Dvořák.

Případová studie: FN Hradec Králové

- Snížení falešně pozitivních diagnóz o 27 %

- Zrychlení procesů o 32 %

- Úspora: 8,5 mil. Kč

- Spokojenost personálu +45 %

„Klíčem byl důraz na etiku a systematické školení.“

— MUDr. P. Horák.

Doporučení AET AI Academy

„AI není jen technologická výzva, ale i společenská odpovědnost.“

— doc. P. Kovář.

Začněte se učit osvětu o AI právě teď:

inventarizace a kategorizace systémů

- Vytvořte dokumentaci a zaveďte auditní stopu

- Budujte etickou kulturu a lidský dohled

- Zajistěte školení napříč organizací

- Zapojte vedení – bez něj to nejde

Závěr

Správa a řízení umělé inteligence v roce 2025 není pouze právní nutností.

Je to otázka společenské odpovědnosti a strategického myšlení.

AI Act přináší příležitost udělat věci správně – bezpečně, eticky a transparentně.

„Správa umělé inteligence není jen o souladu s regulací. Je to nástroj pro zodpovědné řízení budoucnosti.“

— doc. RNDr. Petr Kovář, CSc., odborník na AI governance

🔗 Kontakt: info@aqua-eco-terra.com

�� Datum publikace: 17. května 2025

📢 Vydáno AET AI ACADEMY™ AQUA-ECO-TERRA, z.s.

📝 Tento článek slouží k osvětě a nenahrazuje právní poradenství. Ve smyslu Národní Strategie AI do 2030 vysupuje me coby prvek AI Ekosystému: Občanská společnost, Nevládní organizace s cílem podporovat osvětu AI, výzkum, vzdělávání, etické používání které rozvíjí AI inovační ekosystém, věnují se intenzivně osvětě, vzdělávání a podporují adopci AI ze strany firem, škol i veřejného sektoru. Do trěchto aktivit spadají především další blogové příspěvky na Medium Seznam. Jak bylo již avizováno do konce roku (6.12.2025) plánujeme začít aktivně organizovat minikurzy k základům AI, GenAI.