Článek

Když český vývojář zadá modelu Qwen3-235B-Think stejnou obtížnou otázku v angličtině a v češtině, dostane odpověď téměř identické kvality — propad činí 0,2 procentního bodu. Totéž v jorubštině znamená ztrátu přes 31 bodů. Nejnovější generace velkých jazykových modelů dramaticky zúžila propast mezi angličtinou a velkými evropskými jazyky, ale pro stovky menších jazyků se nůžky naopak rozevírají. A na pozadí probíhá překvapivý proces: i nejpokročilejší modely roku 2025 interně „myslí“ anglicky, i když se jich ptáte česky.

Tato analýza shrnuje současný stav výzkumu vícejazyčného výkonu velkých jazykových modelů na základě srovnávacích testů a studií publikovaných převážně v letech 2024–2025. Zaměřuje se na dvě klíčové otázky: jak jazyk dotazu ovlivňuje kvalitu odpovědi a jak jazyk uvažovacího řetězce ovlivňuje kvalitu výsledku. Obě dimenze jsou kritické pro každého, kdo nasazuje jazykové modely v neanglickém prostředí — od českého vyhledávače po africkou vzdělávací platformu.

Měření propasti: co říkají srovnávací testy roku 2025

Nejkomplexnějším současným nástrojem pro měření vícejazyčného výkonu je hodnoticí sada MMLU-ProX (Xuan et al., 2025), publikovaná na jaře 2025 a přijatá na konferenci EMNLP. V rozšířené verzi z května 2025 pokrývá 29 typologicky různorodých jazyků, obsahuje 11 829 otázek v každém z nich a na rozdíl od standardního MMLU nabízí 10 možných odpovědí místo čtyř, což vyžaduje hlubší uvažování a minimalizuje efekt náhodného hádání. Testováno bylo 36 špičkových modelů.

Výsledky vykreslují jasnou hierarchii. Na špičce stojí Qwen3-235B-Think (Alibaba, květen 2025) s 80,7 % na angličtině. Pro češtinu dosahuje 80,5 % — prakticky nerozlišitelný výsledek. Obdobně minimální propady vykazují francouzština (80,6 %), španělština (80,7 %) a italština (80,9 %, paradoxně nad angličtinou). Na opačném konci spektra stojí wolofština s 36,9 % — absolutní propad 43,8 bodu.

GPT-4.1 (OpenAI, duben 2025) dosahuje na angličtině 79,8 %, na češtině 77,5 % (propad 2,3 bodu), na čínštině 75,5 % a na jorubštině 53,4 %. DeepSeek-R1 (leden 2025) ukazuje na angličtině 79,5 %, na češtině 76,8 % (propad 2,7 bodu) a na wolofštině 58,6 %. Na odlišné, jednodušší hodnoticí sadě MMMLU (vícejazyčné MMLU se čtyřmi odpověďmi) vede Gemini 3.1 Pro (Google, únor 2026) se skóre 92,6 % — čísla z obou sad nelze přímo srovnávat kvůli rozdílné obtížnosti.

Klíčové je, že velikost modelu výrazně ovlivňuje rozsah jazykové degradace. Zatímco velké modely typu Qwen3-235B vykazují pro češtinu propady pod 3 body, menší model DeepSeek-R1-7B dosahuje na angličtině 46,0 %, ale na svahilštině pouhých 10,8 % — propad 35,2 bodu. Malé modely si jednoduše nemohou dovolit „plýtvat“ kapacitou na jazyky, které tvoří zlomek trénovacích dat.

Další hodnoticí sady potvrzují tento vzorec. MGSM (matematické slovní úlohy v 10 jazycích) ukazuje konzistentně nejnižší výkon pro bengálštinu. Belebele od společnosti Meta (122 jazykových variant) prokázal, že výkon koreluje primárně s objemem dat v předtrénovací fázi. BenchMAX (2025, rozšíření GPQA na 16 jazyků) ukázal, že DeepSeek-V3 dosahuje přes 50 % na anglickém a francouzském vědeckém uvažování, ale pod 40 % pro telugštinu.

Obtížnost jako násobitel

Nejpodstatnějším zjištěním výzkumu je, že složitost úlohy exponenciálně zesiluje jazykové rozdíly. Na standardním MMLU, kde stačí vybrat ze 4 odpovědí, již GPT-4 v roce 2023 překonal anglický výkon GPT-3.5 ve 24 z 26 testovaných jazyků — včetně lotyštiny, velštiny a svahilštiny. To vypadalo slibně. Jenže MMLU-Pro, obtížnější varianta s 10 odpověďmi, odhalil výrazně větší propady. A v kombinaci s neanglickým jazykem na MMLU-ProX propady narostly na 30 a více procentních bodů u chudě zdrojových jazyků.

Hodnoticí sada MLRBench (2025) zaměřená na vícejazyčné uvažování nad dlouhými kontexty potvrdila, že degradace je obzvláště výrazná u úloh vyžadujících vícekrokovou inferenci. Krátké faktografické dotazy fungují napříč jazyky srovnatelně; obtížné uvažovací problémy odhalují propastné rozdíly.

Přímý výzkum vlivu délky dotazu ve vícejazyčném kontextu dosud publikován nebyl. Výzkum mezijazykového vyhledávání nicméně naznačuje, že krátké, nejednoznačné dotazy jsou v neanglickém prostředí problematičtější, protože model nemá dostatečný kontext pro určení správného významu.

Myslí modely anglicky?

Tři nezávislé studie z let 2024–2025 konvergují ke stejnému závěru: modely s převahou anglických trénovacích dat zpracovávají informace přes anglické reprezentace i při neanglickém vstupu i výstupu.

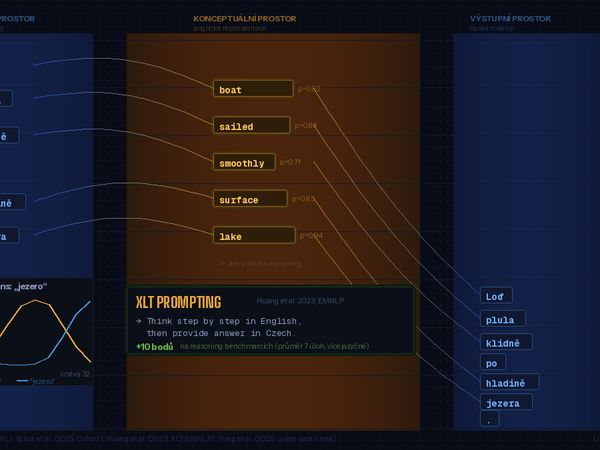

Studie „Do Llamas Work in English?“ (Wendler et al., ACL 2024, EPFL) identifikovala u modelu Llama-2 tři fáze zpracování: vstupní prostor zachycuje povrchové rysy vstupního jazyka, střední vrstvy (konceptuální prostor) přiřazují vyšší pravděpodobnost anglickým tokenům a výstupní vrstvy přeloží výsledek do cílového jazyka.

„Do Multilingual LLMs Think In English?“ (Schut, Gal a Farquhar, ICLR 2025, Oxford/DeepMind) rozšířila analýzu na aktuální modely — Llama-3.1-70B, Mixtral-8×22B, Gemma-2-27B a Aya-23-35B — a testovala je na francouzštině, němčině, holandštině a mandarínštině. Zjistila, že modely nejprve generují reprezentace blízké angličtině pro sémanticky nabitá slova (podstatná jména, slovesa), a teprve poté je přeloží do cílového jazyka. Gramatická slova (členy, předložky) tímto anglickým směrováním neprocházejí. Prakticky důležitý poznatek: aktivační řízení je efektivnější, když jsou vektory počítány v angličtině — i u čistě neanglického vstupu a výstupu.

Míra anglického směrování přitom závisí na složení trénovacích dat. Aya-23-35B (trénovaný na 23 jazycích) byl nejméně anglocentrický, Gemma-2-27B (převážně anglický korpus) nejvíce. Samostatná studie na japonských modelech (Zhong et al., 2024) potvrdila, že LLM-jp (vyvážený japonsko-anglický korpus) primárně používá japonštinu jako interní jazyk, zatímco Llama-2 se při zpracování japonštiny spoléhá výhradně na angličtinu.

Pro praxi to znamená: i když model odpovídá česky, jeho „uvažování“ probíhá v anglickém konceptuálním prostoru. Přechod do cílového jazyka ve výstupních vrstvách je potenciálním zdrojem degradace, zejména u jazyků se specifickou morfologií nebo syntaxí.

Řetězec myšlenek: anglicky, nativně, nebo smíšeně?

Klíčová studie Shi et al. (ICLR 2023) na hodnoticí sadě MGSM prokázala, že anglický řetězec myšlenek (chain-of-thought, CoT) — uvažování v angličtině i na neanglický dotaz — konzistentně dosahuje srovnatelných nebo lepších výsledků než nativní řetězec myšlenek. Oba přístupy masivně překonaly přímé odpovídání bez uvažovacích kroků o 20 až 40 a více procentních bodů. To bylo na modelu PaLM-540B.

Novější výzkum z roku 2025 však přináší nuance specifické pro aktuální modely. Pro francouzštinu anglický prostřednický jazyk nepřináší žádné zlepšení. Pro japonštinu a lotyštinu modely zpracují vstup v nativním jazyce, ale pro optimální výkon potřebují anglický jazyk uvažování. Pro svahilštinu anglický prostřednický jazyk selhává úplně — model má problémy jak s porozuměním, tak s uvažováním.

Nejzajímavějším fenoménem je samovolné míchání jazyků u uvažovacích modelů. DeepSeek-R1 explicitně přiznává, že při neanglickém dotazu může přepínat do angličtiny nebo čínštiny během uvažovacího řetězce. Studie z roku 2025 prokázala, že silnější uvažování koreluje se zvýšeným míchání jazyků. Pokus o potlačení tohoto chování zavedením odměny za jazykovou konzistenci během tréninku výkon paradoxně zhoršil. Naopak: trénovaná sonda pro strategické míchání jazyků přinesla zlepšení na matematických úlohách.

Kontraintuitivní studie „Could Thinking Multilingually Empower LLM Reasoning?“ (2025) zjistila, že vícejazyčné uvažování poskytuje přibližně 10 bodů vyšší horní mez výkonu než čistě anglické uvažování. Jenže standardní metody výběru (majoritní hlasování) tohoto potenciálu nedokáží využít. Jazykový mix je tedy dvojsečná zbraň: zlepšuje rozmanitost uvažovacích cest, ale komplikuje selekci nejlepší odpovědi.

Čeština: příznivá pozice s reálnými mezerami

Na základě MMLU-ProX patří čeština mezi nejlépe obsloužené neanglické jazyky. Špičkové modely vykazují propady pod 3 procentní body. To ji řadí na úroveň velkých románských a germánských jazyků. Detailnější pohled přes české hodnoticí sady ale odhaluje jemnější problémy.

BenCzechMark (publikovaný v TACL, MIT Press, 2025) je nejkomplexnější český hodnoticí soubor s 50 úlohami v 8 kategoriích. Zásadní je, že 90 % obsahu je nativně české, nikoli přeložené. Na žebříčku figurují desítky modelů. V celkovém hodnocení vede Llama-450B (Meta). V jednotlivých kategoriích dominuje Qwen-72B (matematika, vyhledávání informací), Aya-23-35B (sentiment, jazykové modelování) a překvapivě Gemma-2-9B v porozumění českému čtenému textu překonává výrazně větší modely.

MiniCzechBenchmark (2025), který dosahuje korelace vyšší než 0,996 s plnými srovnávacími testy, identifikoval 10–30% propady výkonu mezi angličtinou a češtinou. Největší rozdíly vykazuje matematika (kde existuje podezření na kontaminaci anglickými daty). DeepSeek-R1 dosahuje 78 % na matematice, ale degraduje na českých gramatických úlohách. Nejdůležitější zjištění: modely dokáží správně zodpovědět české otázky s výběrem odpovědí, ale produkují výrazně horší volnou generaci českého textu.

Test na české advokátní zkoušce (1 840 otázek, HAVEL & PARTNERS, 2024) ukázal, že žádný samostatný jazykový model nepřekročil hranici 85 % potřebnou ke složení písemného testu. Nejlépe si vedl Claude-3-Opus, těsně následovaný GPT-4-Turbo. Systém s rozšířeným vyhledáváním (RAG — GPT-4 + právní zdroje) však všechny simulované pokusy složil.

Srovnání nejnovějších modelových rodin

Qwen3 (Alibaba, květen 2025)

Aktuálně nejsilnější vícejazyčný model na MMLU-ProX. Qwen3-235B-Think vykazuje pro evropské jazyky téměř nulový propad oproti angličtině. Deklaruje podporu 119 jazyků a dialektů. Silný v čínštině i angličtině zároveň, což ukazuje, že vyvážené dvojjazyčné předtrénování se vyplácí.

GPT-4.1 (OpenAI, duben 2025)

Propad 2,3 bodu pro češtinu na MMLU-ProX. GPT-4o deklaruje podporu 50 a více jazyků pokrývajících 97 % světových mluvčích. Na vícejazyčném MMLU však přetrvává 25% rozdíl mezi angličtinou a jorubštinou. Oproti GPT-4 (2023) je posun znatelný: GPT-4 tehdy na standardním MMLU překonal anglický výkon GPT-3.5 ve 24 z 26 jazyků, ale na obtížnějších úlohách propady zůstávaly dramatické. GPT-4.1 tyto propady pro bohatě zdrojové jazyky výrazně zmírnil.

DeepSeek-R1 (leden 2025)

Propad 2,7 bodu pro češtinu. Primárně optimalizovaný pro angličtinu a čínštinu. Specifický fenomén: spontánní míchání jazyků během uvažování jako samovolné chování posilujícího učení. Na wolofštině 58,6 % — výrazně nad menšími modely, ale stále 20,9 bodu pod angličtinou.

Gemini 3.1 Pro (Google, únor 2026)

Nejnovější model v analýze. Vede na vícejazyčné hodnoticí sadě MMMLU s 92,6 % (pozor: jiný a jednodušší test než MMLU-ProX, výsledky nelze přímo srovnávat). Oproti Gemini 1.5, který přinesl výrazné zlepšení vícejazyčného výkonu oproti verzi 1.0, představuje další generační skok.

Claude (Anthropic)

Interní hodnocení ukazuje přesnost v rozšířených jazycích na úrovni 95–98 % anglického výkonu. Claude 3 Opus dosahoval přes 90 % na MGSM ve více než 8 jazycích. Pro češtinu vykazuje vysokou gramatickou kvalitu generovaného textu mezi komerčními modely.

Meta Llama

Oficiálně podporuje pouze 8 jazyků. Trénovací korpus Llama-2 obsahoval 89,7 % angličtiny. Přesto nejnovější Llama-450B vede celkově na BenCzechMark. Posun od Llama-2 přes Llama-3 k nejnovější variantě ukazuje, že rozšíření vícejazyčných dat v tréninku přináší výrazné zisky i při zachování anglické dominance.

Mistral (Francie)

Mistral Large 2 překonává Llama 3.1 70B průměrně o 6,3 % napříč devíti jazyky na vícejazyčném MMLU. Jako jediný významný evropský hráč investuje do vícejazyčného výkonu jako strategické výhody oproti americkým a čínským konkurentům.

Skrytá cena: tokenizace

Mimo kvalitu odpovědí existuje ekonomický rozměr jazykové propasti. Analýzy tokenizačních systémů vyčíslily přirážku pro neanglické jazyky: španělský technický odstavec vyžaduje o desítky procent více tokenů než jeho anglická verze. Portugalština a němčina vykazují srovnatelné přirážky. U jazyků s nelatinkovým písmem může být rozdíl ještě dramatičtější — pro některé jazyky jihovýchodní Asie tokenizátor spotřebuje řádově více tokenů na stejný obsah.

Tento efekt se přímo promítá do nákladů na rozhraní API (platí se za tokeny) a do rychlosti zpracování. Česky formulovaný dotaz je tedy nejen potenciálně méně přesně zodpovězen, ale i dražší na zpracování.

Kde je pravda komplikovanější

Celkový obraz jazykové degradace si zaslouží tři protiargumenty.

Za prvé, propady v hodnoticích testech nemusí odpovídat reálnému uživatelskému zážitku. MMLU-ProX testuje akademické znalostní otázky. Běžná konverzace, psaní e-mailů nebo jednoduché programování — tedy typické úlohy většiny uživatelů — mohou vykazovat výrazně menší propady. Studie zaměřené na volnou generaci textu v neanglických jazycích jsou zatím vzácné.

Za druhé, trend směřuje k rychlému zlepšování. Mezi GPT-3.5 (2022) a Qwen3-235B (2025) se propad pro češtinu zmenšil z desítek procentních bodů na zlomky. Extrapolace tohoto trendu naznačuje, že pro bohatě zdrojové jazyky může jazyková daň během příštích dvou let klesnout na statisticky nevýznamnou úroveň.

Za třetí, zjištění o interním „anglickém myšlení“ nemusí být problém, ale vlastnost. Pokud model efektivně využívá anglický konceptuální prostor pro uvažování a kvalitně překládá do cílového jazyka, výsledek může být stejně dobrý jako nativní zpracování. Data z MMLU-ProX pro češtinu tuto interpretaci podporují.

Přesto zůstává platné, že obtížné uvažovací úlohy v chudě zdrojových jazycích jsou prokazatelně horší. Volná generace textu zaostává za výběrovými otázkami. A tokenizační přirážka je reálná ekonomická zátěž, kterou žádný algoritmický pokrok neeliminuje — vyžaduje přetrénování tokenizátoru.

Co z toho vyplývá

Pro vývojáře nasazující jazykové modely v českém prostředí je zpráva převážně pozitivní: na standardních hodnoticích sadách patří čeština mezi nejlépe obsloužené neanglické jazyky s minimálními propady. Problém nastává ve dvou oblastech — volné generaci textu (10–30% propady identifikované v MiniCzechBenchmark) a v doménově specifickém uvažování, kde ani nejlepší model nesložil českou advokátní zkoušku bez rozšířeného vyhledávání.

Optimální strategie závisí na typu úlohy. Pro jednoduché dotazy a konverzaci je český vstup plně adekvátní. Pro obtížné uvažovací úlohy — matematika, logika, komplexní analýzy — zůstává anglický vstup s následným překladem pravděpodobně spolehlivější. Pro uvažovací modely typu DeepSeek-R1 je paradoxně nejlepší nechat model sám rozhodnout o jazyce uvažování, protože potlačení míchání jazyků výkon zhoršuje.

Výzkum vícejazyčného výkonu velkých jazykových modelů je aktivním polem. Dosud chybí studie zaměřené specificky na krátké, nejednoznačné dotazy ve vícejazyčném prostředí a na systematické porovnání kvality volné generace textu napříč jazyky. Také mechanismus, jakým interní anglické zpracování degraduje výstup v morfologicky bohatých jazycích jako čeština, zůstává otevřenou otázkou.

Metodologická poznámka: Analýza vychází z akademických studií a hodnoticích sad publikovaných v letech 2023–2026, s důrazem na data z roku 2025. Hlavní zdroje: MMLU-ProX (Xuan et al., EMNLP 2025), BenCzechMark (TACL/MIT Press, 2025), MiniCzechBenchmark (2025), „Do Multilingual LLMs Think In English?“ (Schut et al., ICLR 2025), „Do Llamas Work in English?“ (Wendler et al., ACL 2024), MGSM (Shi et al., ICLR 2023). Skóre z hodnoticích sad se vztahují k modelům dostupným k únoru 2026. Limity: hodnoticí sady testují převážně výběrové otázky, nikoli volnou generaci; čísla pro nejnovější modely (Gemini 3.1 Pro) pocházejí z jiné sady (MMMLU) než ostatní zde diskutované výsledky; pro specificky české dílčí výsledky je třeba konzultovat aktuální žebříček BenCzechMark.

Transparentnost tvorby:

Koncepce, struktura a redakční linie článku jsou dílem autora, který vypracoval obsahovou skicu, stanovil klíčové teze a řídil celý proces tvorby. Generativní AI (Claude, Anthropic) byla využita jako technický nástroj pro rešerši, ověřování faktů a rozepsání autorovy předlohy.

Autor výstupy průběžně redigoval, ověřil klíčová zjištění a schválil finální znění. Žádná část textu nebyla publikována bez lidské kontroly. Všechny faktické údaje byly ověřeny proti veřejně dostupným zdrojům uvedeným v textu.

Postup je v souladu s požadavky Čl. 50 Nařízení EU 2024/1689 (AI Act) na transparentnost AI-generovaného obsahu. #poweredByAI