Článek

Na podzim 2025 podal pražský advokát Pavol Kehl k Ústavnímu soudu stížnost za klienta, který neuspěl u správních soudů se žalobami na odmítnutí povolení k přechodnému pobytu. Po formální stránce působila stížnost bezvadně. Jenže z dvanácti rozhodnutí Ústavního soudu a Evropského soudu pro lidská práva, na která v textu odkazoval, podstatná část vůbec neexistovala a zbytek byl hrubě dezinterpretován. Advokát při psaní použil nástroj založený na umělé inteligenci a výsledek dostatečně neověřil. Předseda senátu Tomáš Langášek mu 1. prosince 2025 uložil pořádkovou pokutu 25 000 Kč za hrubé ztěžování postupu řízení. Česká advokátní komora případ prověřovala.

Na druhé straně téhož spektra stojí systém WAIR, který v testových podmínkách jako jediný systém s umělou inteligencí českou advokátní zkoušku prokazatelně složil. Mezi těmito dvěma extrémy se odehrává příběh, který se v roce 2026 rychle mění: nejpokročilejší modely jako GPT-5, Gemini 3 Pro nebo Claude 4.5 Sonnet vykazují na mezinárodních právních srovnávacích testech výkon, o kterém se před dvěma lety nikomu nezdálo. Na české právo je ale zatím nikdo systematicky nepustil.

Tento článek analyzuje, jak daleko se schopnosti nejnovějších velkých jazykových modelů v právním uvažování posunuly, proč české právo zůstává specifickou výzvou a co to znamená pro advokáty, soudy i regulátory.

Březnový test 2024: jediný tvrdý datový bod

Jedinou systematickou zkouškou výkonu umělé inteligence na české advokátní zkoušce zůstává test zveřejněný 28. března 2024 Jiřím Nečasem a Daliborem Kovářem z kanceláře HAVEL & PARTNERS. Testovali osm modelů na sadách z banky 1 840 oficiálních otázek České advokátní komory — pět kol po stu otázkách, tedy 500 otázek na každý model. Správná je vždy jedna ze tří nabídnutých možností, práh pro úspěch činí 85 %. Výsledky byly jednoznačné:

WAIR (GPT-4 + rozšířené generování s vyhledáváním + české právní databáze) — nad 85 % ve všech 5 kolech. Jediný, kdo zkoušku složil.

Claude-3-Opus — nejlepší ze samostatných modelů, pod 85 %. Nesložil.

GPT-4-Turbo — těsně za Claude-3-Opus. Nesložil.

Gemini-1.0-Pro — s odstupem. Nesložil.

GPT-3.5-Turbo — sotva přes 50 %. Nesložil.

Test odhalil, že trestní právo bylo pro většinu modelů nejtěžší oblastí (výjimkou byl Gemini-1.0-Pro, pro který šlo naopak o nejsilnější disciplínu). Zásadní omezení: testována byla pouze písemná část s výběrem odpovědí, nikoli písemná argumentace ani ústní zkouška.

Od března 2024 se ale krajina velkých jazykových modelů proměnila dramaticky. Modely, které tehdy neexistovaly, dnes na mezinárodních právních srovnávacích testech dosahují výkonů, které by v testu HAVEL & PARTNERS s vysokou pravděpodobností překonaly hranici 85 %. Jenže — nikdo to neověřil.

Nejpokročilejší modely 2025–2026: co ukazují mezinárodní srovnávací testy

LegalBench: Gemini 3 Pro vede s 87 %

Na platformě LegalBench — 162 úloh amerického práva pokrývajících identifikaci pravidel, aplikaci práva a právní interpretaci — vede k únoru 2026 Gemini 3 Pros přesností 87,04 %. Za ním následují Gemini 3 Flash (86,86 %), GPT-5 (86,02 %) a GPT-5.1 (85,68 %). Starší GPT-4o dosahoval přibližně 78 %, o1 Preview kolem 80 %. Nárůst o 7–9 procentních bodů za necelé dva roky ilustruje tempo pokroku.

Důležité je však upozornění samotných autorů: výkon modelů se dramaticky liší mezi úlohami. Model, který vyniká v identifikaci právního pravidla, může selhávat v jeho aplikaci na konkrétní skutkový stav. Právní uvažování není monolitická kompetence.

LEXam: otevřené otázky jako slabé místo

Srovnávací test LEXam (ETH Zurich, Universität Zürich a další instituce; květen 2025, průběžně aktualizováno) představuje dosud nejnáročnější zkoušku — 4 886 otázek z 340 právních zkoušek v angličtině a němčině, včetně 2 841 otevřených otázek vyžadujících strukturovanou právní argumentaci.

Výsledky jsou střízlivější než u testů s výběrem odpovědí. V původní verzi paperu z května 2025 dosáhl nejvyššího celkového průměrného skóre Gemini-2.5-Pro (82,2), následovaný modelem Claude-3.7-Sonnet. Modely s rozšířeným uvažováním (Gemini-2.5-Pro, Claude-3.7-Sonnet, o3-mini) výrazně překonávají konvenční velké jazykové modely, ale i ony se viditelně potýkají s víceúrovňovým právním uvažováním: identifikací problému, vybavením příslušného pravidla a jeho aplikací na skutkový stav.

Klíčové zjištění LEXam: zvyšování počtu voleb u otázek s výběrem konzistentně snižuje přesnost modelů. Se čtyřmi volbami dosahují nejpokročilejší modely 80–90 %, se třiceti dvěma volbami klesají pod 60 %. To je relevantní pro českou zkoušku, která má sice jen tři volby, ale obsahuje formulačně jemné rozdíly vyžadující přesnou znalost českého práva.

Brazilská zkouška: Claude 3.5 Sonnet prošel všemi 21 termíny

Na brazilské advokátní zkoušce (oab-bench, duben 2025, 105 otázek z písemné části) Claude 3.5 Sonnet prošel všemi 21 zkušebními termíny s průměrným skóre 7,93 z 10. Výsledky dalších modelů byly slabší. Studie ukázala, že Claude vynikal v ústavním a trestním právu.

Proč je české právo stále jiný svět

Mezinárodní srovnávací testy ukazují působivý pokrok, ale přenášet je přímo na české právo je metodologicky problematické. Existují tři strukturální bariéry, které českou advokátní zkoušku odlišují od anglických testů.

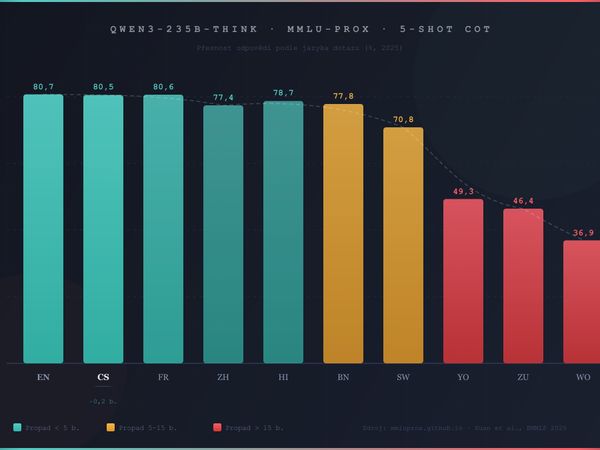

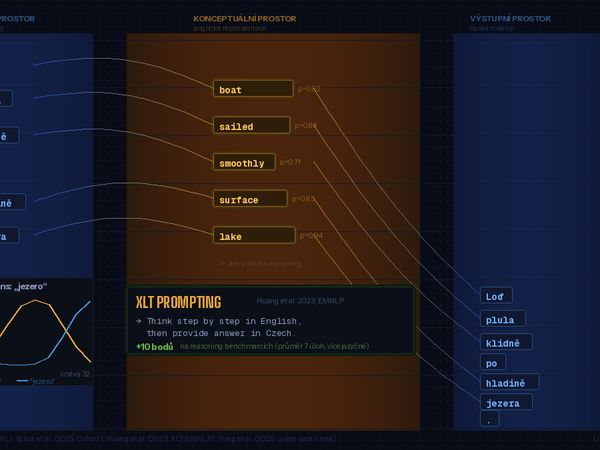

1. Jazyková propast

Studie Arnetta a Bergena (listopad 2024) prokázala, že výkonnostní mezera u morfologicky bohatých jazyků koreluje primárně s objemem trénovacích dat, nikoli s lingvistickou složitostí. Průřezová měření výkonu modelů na neangličtině, včetně českého srovnávacího testu BenCzechMark (50 úloh, 90 % nativně českého obsahu, publikováno v Transactions of the ACL, 2025), ukazují, že modely dosahují na českých úlohách znatelně horších výsledků než na srovnatelných anglických. Odborná literatura odhady propasti typicky uvádí v rozmezí 10–30 % v závislosti na typu úlohy a modelu.

BenCzechMark navíc ukázal, že celkový skóre na výběrových otázkách nemusí odpovídat kvalitě generovaného českého textu — model může správně odpovídat na české otázky, ale generovat nekvalitní český text.

Příčinou není inherentní obtížnost češtiny, ale nepoměr v trénovacích datech. Řešení tedy existuje — vyžaduje ale investice do českých korpusů.

2. Kontinentální právo versus systém obecného práva

Kontinentální právní systémy, mezi něž české právo patří, staví před umělou inteligenci odlišné výzvy než angloamerický systém obecného práva (common law). Generální klauzule — pojmy jako „dobré mravy“ nebo „přiměřenost“ — jsou záměrně neurčité a nelze je řešit pouhým vyhledáváním informací. Mezery v právu vyžadují analogické uvažování. Hierarchie norem (lex specialis, lex posterior) předpokládá pochopení systémových vztahů. Judikatura, která je nezávazná, ale přesvědčivá, operuje v šedé zóně mezi právem a praxí. A proměnlivá důkazní břemena vyžadují kontextuální posouzení, které překračuje možnosti prostého rozpoznávání vzorců.

Americký MBE test s jeho logikou obecného práva je pro velké jazykové modely přirozenější terén: bohatá judikatura nabízí vzorce, které se dobře učí. České kodifikované právo vyžaduje systematický výklad, nikoli vyhledávání precedentů.

3. Práh 85 % — jeden z nejvyšších na světě

Česká advokátní zkouška vyžaduje 85 % úspěšnost v písemné výběrové části. Americký UBE má fakticky nižší práh. Japonská zkouška požaduje 93 ze 175 bodů (53 %). Tento rozdíl znamená, že i model dosahující solidních 78–80 % na českém testu by neprošel.

Rozšířené generování s vyhledáváním jako rozhodující faktor: poučení z WAIR

Klíčovým zjištěním testu HAVEL & PARTNERS není výkon jednotlivých modelů, ale propastný rozdíl mezi samostatným velkým jazykovým modelem a systémem s přístupem k českým právním zdrojům. WAIR — kombinující agenty GPT-4 s technikou rozšířeného generování s vyhledáváním (RAG) a českými právními databázemi — zkoušku složil ve všech pěti kolech. Nejlepší samostatný model (Claude-3-Opus) nikoli.

Toto zjištění se potvrzuje i mezinárodně. Na japonské advokátní zkoušce uspěl doladěný model se samoopravným mechanismem, nikoli základní GPT-4. Na srovnávacím testu LEXam autoři konstatují, že modely s rozšířeným uvažováním a přístupem k relevantním zdrojům výrazně překonávají modely bez kontextu.

Pro české právo to má přímou implikaci: rozhodující není, jak „chytrý“ je samotný model, ale zda má přístup k aktuálním, kvalitním českým právním zdrojům. WAIR toto ověřil empiricky. S nejpokročilejšími modely roku 2026 (GPT-5, Gemini 3 Pro, Claude 4.5 Sonnet) by systém s rozšířeným generováním a českou právní databází s vysokou pravděpodobností dosáhl ještě výrazně lepších výsledků — ale jde o neověřenou hypotézu.

Česká scéna: mezi pokutami a inovacemi

Kauza Kehl z prosince 2025 ilustruje riziko nekritického používání umělé inteligence v právu. Ale stejně tak ukazuje, že problémem není technologie samotná, nýbrž absence procesů pro její odpovědné nasazení.

Česká advokátní komora v září 2023 vydala stanovisko: umělá inteligence nemůže poskytovat právní služby, lze ji používat pouze jako nástroj a advokát nese plnou odpovědnost. V lednu 2026 přeložila Pokyny CCBE pro používání generativní umělé inteligence advokáty a Sekce ČAK pro umělou inteligenci pod vedením Barbory Vlachové připravuje aktualizovanou strategii.

Inovační proud reprezentuje Advokátní asociace pro AI (založena v červenci 2024) a produkty jako WAIR(HAVEL & PARTNERS), Lawrence AI (projekt studentů PF UK) a AI Advokát (kancelář Petráš Rezek).

Na akademické úrovni hraje klíčovou roli projekt OpenEuroLLMkoordinovaný Univerzitou Karlovou (prof. Jan Hajič, ÚFAL MFF UK) s rozpočtem 34 milionů EUR — cílí na otevřené, vícejazyčné velké jazykové modely pro evropské jazyky, kompatibilní s Nařízením EU o umělé inteligenci. Tyto modely by mohly být doladěny pro české právo bez obav z narušení advokátní mlčenlivosti, jaké provázejí používání uzavřených amerických modelů.

Co chybí: otevřený srovnávací test českého právního AI

Největší problém celé diskuse není v tom, zda umělá inteligence „umí“ české právo — ale v tom, že to nikdo systematicky neměří. Test HAVEL & PARTNERS je cenný, ale proprietární a omezený na výběrový formát s modely z března 2024. České srovnávací testy BenCzechMark a CzechBench neobsahují specializované právní úlohy. Neexistuje otevřený, reprodukovatelný srovnávací test českého právního AI.

To znamená, že diskuse o umělé inteligenci v českém právu se — jak trefně poznamenali autoři testu HAVEL & PARTNERS — stále opírá spíše o nahodilé zkušenosti než o tvrdá data.

Co by takový srovnávací test vyžadoval? Za prvé, rozšíření testů s výběrem odpovědí na aktuální nejpokročilejší modely (GPT-5, Gemini 3 Pro, Claude 4.5 Sonnet, o3). Za druhé, doplnění o písemnou argumentační část — LEXam ukázal, že právě otevřené otázky jsou kritickým rozlišovacím faktorem. Za třetí, testování systémů s rozšířeným generováním a českými právními databázemi vedle samostatných modelů. A za čtvrté, otevřenou metodologii umožňující reprodukci a aktualizaci.

Výhled: co můžeme očekávat

Na základě dostupných dat lze formulovat tři kvalifikované odhady.

Za prvé, nejpokročilejší modely roku 2026 by s rozšířeným generováním a kvalitní českou právní databází s vysokou pravděpodobností překonaly 85 % práh na výběrové části české advokátní zkoušky. Extrapolace z LegalBench (87 % pro Gemini 3 Pro na anglickém právu) minus odhadovaná jazyková penalizace (10–15 % pro češtinu) dává hrubý odhad kolem 74–78 % pro samostatný model. Se systémem rozšířeného generování by výsledek mohl být nad 90 %. Toto ale zůstává neověřenou projekcí — ne předpovědí.

Za druhé, písemná a ústní část zkoušky zůstává výrazně tvrdším oříškem. LEXam ukazuje, že i nejlepší modely dosahují na otevřených právních otázkách podstatně nižších skóre než na výběrových testech — a to v angličtině a němčině. V češtině by výkon byl nižší.

Za třetí, praktický dopad umělé inteligence na českou advokacii bude záviset méně na schopnostech modelů a více na infrastruktuře — kvalitě českých právních databází, dostupnosti nástrojů s rozšířeným generováním, regulačním rámci ČAK a vzdělávání advokátů v odpovědném používání umělé inteligence.

Metodologická poznámka

Tento článek vychází z následujících primárních zdrojů: test HAVEL & PARTNERS (zveřejněn 28. března 2024), srovnávací test LegalBench (vals.ai, aktuální k únoru 2026), srovnávací test LEXam (arxiv:2505.12864, květen 2025, průběžně aktualizováno), srovnávací test oab-bench (arxiv:2504.21202, duben 2025), srovnávací test BenCzechMark (Transactions of the ACL, 2025), studie Arnetta a Bergena (2024). České institucionální zdroje: Advokátní deník, iROZHLAS, Česká justice, Lupa.cz.

Hlavní limity analýzy: absence aktuálního testu nejpokročilejších modelů na české advokátní zkoušce (poslední data z března 2024), proprietární charakter testu HAVEL & PARTNERS neumožňující nezávislou replikaci a extrapolace z anglických a německých srovnávacích testů na české právo, která nemusí být spolehlivá.

Transparentnost tvorby:

Koncepce, struktura a redakční linie článku jsou dílem autora, který vypracoval obsahovou skicu, stanovil klíčové teze a řídil celý proces tvorby. Generativní AI (Claude, Anthropic) byla využita jako technický nástroj pro rešerši, ověřování faktů a rozepsání autorovy předlohy.

Autor výstupy průběžně redigoval, ověřil klíčová zjištění a schválil finální znění. Žádná část textu nebyla publikována bez lidské kontroly. Všechny faktické údaje byly ověřeny proti veřejně dostupným zdrojům uvedeným v textu.

Postup je v souladu s požadavky Čl. 50 Nařízení EU 2024/1689 (AI Act) na transparentnost AI-generovaného obsahu. #poweredByAI