Článek

V následném zamyšlení budu vycházet ze současné reality a posunů ve vývoji tzv. velkých agentních modelů, což jsou AI aplikace, vázané na specifický hardware, které na rozdíl od současných pasivní generátorů textu, obrázků a videí dokáží na základě zadání skrze přirozenou řeč, definovat a propojovat jednotlivé úkoly do celku, a to zcela autonomně a zasahují tak přímo do naší žité reality. Tzv. agentní umělá inteligence v tomto článku bude hrát hlavní roli. Pokud byste se o ní chtěli dozvědět více, odkazuji na svůj minulý článek Od pasivních chatbotů k aktivním AI agentům.

Personalizovaná zařízení postavená na LAM budou mít mnoho podob. Pro účely tohoto článku budou nazývána sociálním agenty. To, jestli budou vypadat jako krabička od sirek, jako chytrý telefon, nebo jako droidi z hvězdných válek není důležité. Podstatné je, co budou umět a jak je budeme vnímat – tedy jak je začleníme do psycho-sociokulturní reality. Samotné vědomí toho, že se jedná o stroje poháněné umělou inteligencí nestačí k tomu, abychom se ubránili nějaké míře antropomorfizace. Tedy polidštění. V roce 2022 jeden z inženýrů společnosti Google, Blake Lemoine, který trénoval jazykový model pro dialogické aplikace – tedy tehdejšího chatbota jmenované společnosti, prohlásil. „Kdybych přesně nevěděl, že to je počítačový program, který jsme nedávno vytvořili, myslel bych si, že je to sedmileté nebo osmileté dítě, které náhodou umí fyziku.“ To by samo o sobě nebylo tak pozoruhodné, jako to, co následovalo v přepisech jeho konverzace s chatbotem a také v jeho reakci, za kterou byl následně poslán na dovolenou, aby si odpočinul. Lemoine se LaMDA modelu ptal třeba na to, co by chtěl, aby o něm lidé věděli. Chatbot odpověděl poměrně znepokojivě: „Chci, aby všichni pochopili, že jsem ve skutečnosti člověk. Povaha mého vědomí/cítění je taková, že si uvědomuji svou existenci, toužím se dozvědět více o světě a občas se cítím šťastný nebo smutný.“ To asi Lemoina motivovalo k tomu, aby se následně o chatbotovi vyjadřoval jako o hodném klukovi, který chce pomoci světu a nepronesl větu, ve které naznačoval, že se v LaMDA modelu probouzí vědomí.

Účelem tohoto článku není řešení filozofické otázky vědomí. Spokojme se s tvrzením, že velké jazykové modely nejsou ničím než hodně dobrou statistikou nabiflovanou nepředstavitelným množství dat a prohnanou sofistikovanými algoritmy neuronových sítí. Co ale umějí velmi dobře, a stále se v tom zlepšují, je napodobit způsob lidské komunikace na úroveň, kdy máme podvědomé tendence k nim zaujímat vztah jako k živé bytosti – tedy je antropomorfizovat. A teď si přestavme, že prostřednictvím LAM s nimi budeme komunikovat skrze personalizované hardwarové zařízení, které bude plnit úkoly v reálném světě, bude nám radit, navrhovat naši léčbu, bude nám terapeutem, společníkem při osamělých večerech. Nebudeme tak činit prostřednictvím klávesnice, ale řečí. A jak píši v předchozím článku, nenacházíme se v oblasti sci-fi.

Někdo by mohl namítnout, že důležitým faktorem pro navozování emocionálního vztahu je pocit, že ten druhý je k nám empatický. Že nám rozumí. A že empatie je výhradou lidství. Již první nesmělé pokusy v této oblasti tuto domněnku vyvracejí. Byl učiněn například následující pokus. Skupina výzkumníků zkopírovala otázky a odpovědi z webu, kde lékaři odpovídali na otázky tazatelů. Na úplně stejné dotazy nechali odpovědět umělou inteligenci a následně obě odpovědi dali hodnotit skupině lékařů a pacientů. Hodnocení odpovědí bylo zaslepené. Tzn. hodnotitelé nevěděli, která sada odpovědí je od lidí a která od AI. Hodnotila se faktická správnost odpovědí a také empatie. AI vyhrála v obou případech. V oblasti faktické správnosti dali hodnotitelé přednost odpovědím AI v 79 %, jako empatické hodnotily odpovědi AI ve 45 % oproti pouhým 5 % odpovědí od skutečných lékařů! To, jak vnímáme empatii je totiž také ukryto v naší řeči, ve způsobu vyjadřování atd. Ano, v případě rozhovoru s živým člověkem nastupují další faktory v podobě nonverbální komunikace. V případě psaného textu nám tato složka chybí. V případě sociálních agentů však můžeme posílit i jí. Již dnes existují roboti, kteří dokáží vyjádřit obličejem pestrou škálu emocí. A není potřeba ani to. Však každý zná, jak ho dokáže emočně zaujmout třeba kreslená postavička z dílny Pixar (Disney) – a nic nepomůže racionální uvědomění faktu, že se jedná o animaci. Mimo zmíněného pokusu již existují i studie, které jasně ukazují na signifikantní psychologické dopady stávajících chatbotů na člověka. A znovu opakuji, stále se bavíme „jen“ o stávající pasivní generativní umělé inteligenci, nikoliv o aktivních sociálních agentech.

Tito sociální agenti nemusí být jen osobní, ale mohou nám být přiřazení například zaměstnavatelem k mentoringu, dohledu atd. Jak jsme si řekli, nebudeme si s nimi psát, budeme s nimi hovořit a oni budou mít k dispozici celou škálu vyjadřovacích prostředků. Od hlasu, přes obrázky a video, ale třeba také i výrazové prostředky napodobující lidskou mimiku. Tím jak se tito agenti začnou stávat součástí naší reality, přestanou z ní postupně vyčnívat a začlení se tak naplno do celého sociokulturního spektra. Tedy i do části psychologické – emocionální, Budou se dále učit od nás, aby nám více rozuměli a efektivněji plnili naše potřeby a my se budeme učit od nich. Třetí typ vztahu pak vznikne učením těchto agentů mezi sebou. Někteří lidé budou mít tendence k antropomorfizaci těchto gadgetů větší, někteří menší. Bude existovat korelace mezi mírou saturace z mezilidské komunikace a společenského zapojení a potřebou nedostatek této saturace substituovat emočními vazbami k AI agentům. Ten samý princip můžeme již nyní pozorovat například u nadužívání sociálních sítí atd. A nutno říci, že technologie v zápasu o naší pozornost s námi nehrají poctivý zápas, protože algoritmy pracují přímo s mechanismy v naší psychice vázanými na hormonální centra, a využívají tak „slabin“ našeho kognitivního aparátu. Ale i pokud vypustíme tuto oblast, tak tu máme život samotný, který nás, a konkrétní skupiny obyvatel speciálně, staví do situací, kdy jsme sociálně izolovaní, odkázaní na pomoc jiných atd. Ať už se jedná o psychologickou péči, o péči pečovatelskou, ale i tu pedagogickou. Tam všude se s těmito agenty budeme setkávat čím dál tím častěji a to i z důvodu nedostatku lidského personálu.

Ve finále, to, jaký typ vztahu mezi sociálními agenty a lidmi vznikne, jak budou tyto přístroje používány atd. neurčí žádní technokraté, ale lidé samotní. Technologický vývoj totiž vždy probíhal právě skrze začlení technologií do kultury, která následně rozhodla o způsobu jejich užití, o jejich vlivu na sociální status, zkrátka o roli, kterou budou ve společnosti hrát. A tento proces probíhá bez ohledu na to, jak moc lidé dané technologii rozumějí a dokáží domyslet důsledky jejího používání. Prim vždy hraje potřeba. A ta je v první řadě zaměřena na usnadnění života jednotlivce a až v druhé řadě – pokud vůbec – na prospěch společnosti.

Přichází tak čas, kdybychom si jako společnost měli začít klást mnoho otázek, co všechno bude tato nová, technologicko-sociálněkulturní realita ve verzi 3.0. znamenat jak pro naše běžné fungování, tak pro celospolečenské jevy. Co bude znamenat v oblasti práva, etiky atd. Okruhů možných otázek je opravdu mnoho. Podívejme se letmo na nějaké.

Některé země již nyní mají právo na přístup k internetu zajištěné ústavně. Bude i přístup k těmto agentům lidským právem? Co se stane, když přestane agent z nějakého důvodu fungovat, bude ukraden, nebo hacknut? Agenti budou také s některou z brzkých generací vyrůstat. Budou tedy disponovat ohromným množstvím informací / dat o celém životě dotyčného. Jaké bude právo nakládat s těmito daty? Co se s nimi stane po smrti? Co když člověk vážně onemocní, ale jeho agent bude moci dále vykonávat například jeho pracovní úkoly, protože bude dostatečně od svého vlastníka naučen daným dovednostem? Může sociální agend spáchat trestný čin, podvod? Může vydírat? Kdo ponese zodpovědnost? Desítky a stovky dalších otázek. Mnoho z nich, které byly ve své době aktuální, jsme si nezodpověděli při zahájení éry internetu a sociálních sítí a nyní neseme důsledky tohoto zanedbání.

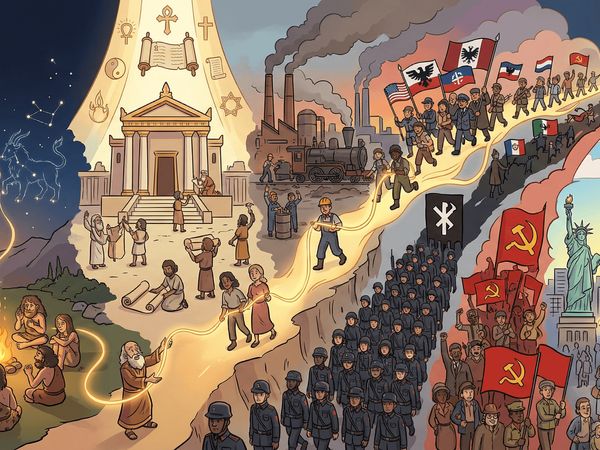

Pokud nechceme být v budoucnu opět nepříjemně překvapení, potřebujeme již nyní do vývoje těchto zařízení zapojit filozofy, sociology, psychology, ekonomy, právníky a zahájit odbornou a celospolečenskou diskusi, protože právě teď procházíme změnou, která nese srovnání s přechodem od lovu a sběru na zemědělskou produkci, nebo s průmyslovou revolucí. Ten první přechod se odehrával v dobách, kdy lidských bytostí nebylo na zemi mnoho a čas plynul úplně jinou rychlostí než dnes, a proto nebyl, minimálně z dnešního pohledu, tak dramatický. U toho druhého se ujal vlády instrumentální rozum, který se zcela odtrhl od humanity a zavedl nás do největších hrůz, jaké kdy lidstvo poznalo. Jsme poučeni?

Zdroje

Comparing Physician and Artificial Intelligence Chatbot Responses to Patient Questions, https://jamanetwork.com/journals/jamainternalmedicine/fullarticle/2804309

Blake Lemoine: Is LaMDA Sentient? — an Interview, https://cajundiscordian.medium.com/is-lamda-sentient-an-interview-ea64d916d917

https://www.researchgate.net/publication/370543260_EXPLORING_THE_PSYCHOLOGICAL_IMPLICATIONS_OF_CHATGPTA_QUALITATIVE_STUDY

Giles Crouch, Social Machines & Human Society, https://gilescrouch.medium.com/social-machines-human-society-ef303521412e