Článek

Analýza — únor 2026

Škálovací zákony slibovaly, že stačí přidat víc dat, parametrů a výpočetního výkonu — a modely budou chytřejší. V roce 2026 víme, že to tak jednoduché není. Příběh klesajících mezních výnosů je ale složitější, než naznačují titulky.

V únoru 2025 OpenAI vydalo model, který měl být GPT-5. Byl výrazně větší než GPT-4, trénovaný s podstatně větším compute. Výsledek byl natolik zklamáním, že ho firma pojmenovala GPT-4.5. Sam Altman ho při představení označil za „obrovský, drahý model“, který „nebude drtit benchmarky“. Když tvůrce nejambicióznějšího AI projektu na světě takto představuje svůj nový produkt, něco se změnilo.

O půl roku později, v srpnu 2025, přišel skutečný GPT-5. Na Polymarketu, predikčním trhu, mělo OpenAI před prezentací přibližně osmdesátiprocentní šanci, že bude mít vedoucí AI model. Po prezentaci se číslo propadlo na zhruba čtrnáct procent. Google vystoupal na přibližně osmdesát pět. To není reakce na špatný model — GPT-5 je objektivně schopnější než cokoli před ním. Je to reakce na zklamaná očekávání. Skok z GPT-3 na GPT-4 změnil odvětví. Skok z GPT-4 na GPT-5 ho nezměnil.

Toto je příběh o tom, proč — a co to znamená pro budoucnost umělé inteligence.

Co jsou škálovací zákony

V roce 2020 tým z OpenAI vedený Jaredem Kaplanem publikoval článek, který se stal jedním z nejcitovanějších v historii AI výzkumu. Zjistili, že výkon jazykových modelů (měřený jako testovací loss — míra nepřesnosti) se zlepšuje předvídatelně s růstem tří veličin: počtu parametrů modelu, objemu trénovacích dat a množství použitého compute. Vztah má tvar mocninného zákona — hladká, předvídatelná křivka, která se na logaritmickém grafu jeví jako přímka.

Dva roky poté tým DeepMind vedený Jordanem Hoffmannem publikoval studii známou jako „Chinchilla paper“, která upřesnila poměry: pro optimální využití výpočetního rozpočtu je třeba škálovat parametry i data současně. Model Chinchilla s 70 miliardami parametrů překonal 280miliardový Gopher, protože byl trénován na čtyřikrát více datech. Poučení: nejde jen o velikost, jde o rovnováhu.

Tyto dva články — Kaplan a Chinchilla — se staly kompasem celého odvětví. Pokud výkon předvídatelně roste s compute, stačí investovat víc peněz do větších clusterů a pokrok je zaručen. Projekt Stargate (500 miliard dolarů, 400 000 GPU) je logickým důsledkem tohoto přesvědčení.

Optická iluze logaritmických os

Toby Ord, filozof z Oxfordu a autor knihy The Precipice, v sérii esejů z roku 2025, začínající textem „The Scaling Paradox“, upozornil na něco, co většina komentátorů přehlížela. Ty hladké, slibně vypadající grafy v původních článcích mají obě osy logaritmické. Na normálním grafu by stejná data vypadala dramaticky jinak.

Konkrétní příklad z Kaplanova článku: snížení testovacího lossu na polovinu (z 6 na 3) vyžaduje milioninásobné zvýšení compute. To není slibná křivka — to jsou extrémní klesající výnosy. Ordovými slovy: přesnost modelu je „mimořádně necitlivá“ na škálování zdrojů. Exponent v mocninném zákoně je velmi malý (kolem 0,05 pro compute). To znamená, že zdvojnásobení compute přinese zlepšení přesnosti o pouhá tři procenta.

V informatice se exponenciální spotřeba zdrojů pro lineární zisk obvykle považuje za signál, že problém je pro daný přístup neřešitelný. Ord argumentuje, že přesně to nám škálovací zákony říkají — jen to prezentují na grafech, které tuto skutečnost vizuálně maskují.

Co se stalo v praxi

Teorie předpovídá klesající výnosy. Co říkají data z posledních dvou let?

GPT-4.5, představené v únoru 2025, bylo „čistým“ testem škálování — větší model, více dat, více compute, stejná architektura. Zlepšení oproti GPT-4 bylo měřitelné, ale nikoliv transformativní. Sam Altman to přiznal veřejně.

Meta odložila Llama 4 Behemoth, protože se podle interních zdrojů nezlepšoval dostatečně dramaticky. Google potichu opustil některé ambiciózní škálovací projekty. Bloomberg, The Information i Reuters nezávisle reportovaly, že přední laboratoře narážejí na strop.

GPT-5, vydaný v srpnu 2025, tento trend potvrdil i vyvrátil zároveň. Na benchmarcích je impozantní — 74,9 procenta na SWE-bench Verified (řešení reálných GitHub issues), 94,6 procenta na AIME 2025 bez nástrojů (v konfiguraci Pro se zapnutým Python interpretem dokonce 100 procent), dramatický skok na ARC-AGI-2. Ale skok nebyl ani zdaleka tak velký jako z GPT-3 na GPT-4. A GPT-5.2 z prosince 2025, ačkoliv dosáhl perfektních skóre na některých benchmarcích, vyvolal na komunitních fórech a predikčních trzích vlnu zklamání.

Klíčový paradox: modely jsou objektivně lepší. Ale zlepšení se zpomaluje. A uživatelé, zvyklí na exponenciální skoky, vnímají inkrementální pokrok jako stagnaci.

Tři zdi

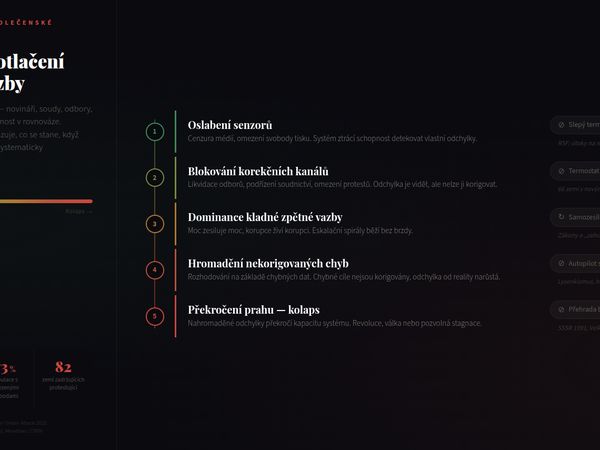

Škálování nenaráží na jednu zeď, ale na tři — a každá vyžaduje jiné řešení.

Datová zeď. Epoch AI odhaduje celkový objem veřejně dostupného kvalitního textu na internetu na přibližně 300 bilionů tokenů. Při současném tempu over-trainingu (více než 200 tokenů na parametr) dojdou kvalitní trénovací data někdy mezi lety 2026 a 2032. Ilya Sutskever to na NeurIPS 2024 shrnul: „Pre-training, jak ho známe, skončí.“ Syntetická data — texty generované jinými modely — jsou potenciálním řešením, ale přinášejí riziko „model collapse“ — degenerace, kdy model trénovaný na vlastních výstupech postupně ztrácí diverzitu.

Energetická zeď. Projekt Stargate spotřebuje řádově gigawatty. Další škálování vyžaduje nové elektrárny — a ty se nestaví za měsíce. Náklady na trénink frontier modelů rostou z milionů na miliardy dolarů. V určitém bodě se investice stává ekonomicky neracionální: pokud zdvojnásobení compute přinese tříprocentní zlepšení, ale stojí miliardu dolarů, návratnost investice prudce klesá.

Zeď benchmarků. Benchmarky saturují. MMLU, donedávna standardní měřítko, byl v roce 2025 prakticky vyřešen — frontier modely dosahují skóre přes 90 procent. Nové benchmarky (MMLU-Pro, GPQA, ARC-AGI-2) jsou těžší, ale i ty se řeší rychleji, než autoři očekávali. ARC Prize oznámil přípravu ARC-AGI-3 na začátek 2026, protože ARC-AGI-2 bude brzy saturován. Když se benchmarky řeší rychleji, než se stačí vytvářet, otázkou je, zda měří skutečnou inteligenci, nebo schopnost optimalizovat na konkrétní formát testu.

Nové dimenze škálování

Příběh ale nekončí konstatováním, že „škálování selhalo“. Přesněji řečeno: škálování pre-trainingu naráží na limity. Ale otevírají se nové dimenze.

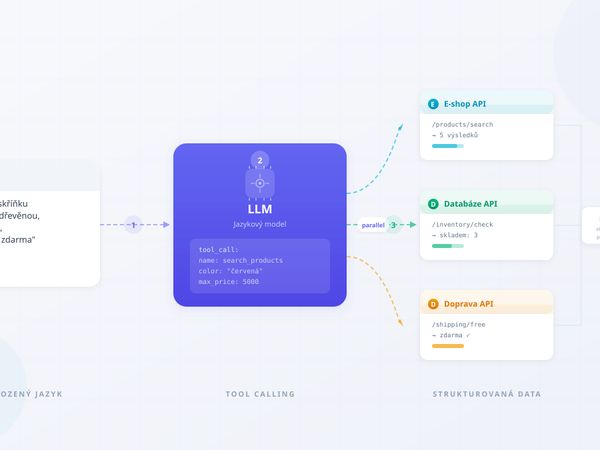

Inference-time compute — paradigma zavedené modely OpenAI o1 a o3 — přesunuje výpočetní výkon z tréninku do inference. Model „přemýšlí“ déle nad odpovědí, rozkládá problém na kroky, ověřuje vlastní uvažování. To je kvalitativně jiný přístup než prosté škálování: místo většího mozku dáváte existujícímu mozku víc času na přemýšlení.

Výsledky jsou pozoruhodné. OpenAI o3 dosáhl na AIME skóre, které by ho zařadilo mezi nejlepší lidské matematiky. Na Codeforces překonal 99,8 procenta lidských programátorů. Ale i tady se objevují klesající výnosy: graf výkonu versus inference compute vykazuje logaritmický tvar. Víc přemýšlení pomáhá, ale každá další minuta přemýšlení pomáhá méně.

Post-training optimalizace — RLHF, DPO, constitutional AI a další techniky, které vylepšují hotový model bez nového pre-trainingu — se staly hlavní cestou ke zlepšení. GPT-5 je do značné míry produktem post-trainingu: stejná (nebo podobná) základna jako GPT-4.5, ale výrazně vylepšená pomocí reinforcement learningu a lidské zpětné vazby. Tým z Epoch AI zjistil, že algoritmická efektivita se zdvojnásobuje přibližně každých osm měsíců — to znamená, že za stejný výkon potřebujete polovinu compute.

Specializace a mixture-of-experts (MoE) — místo jednoho obrovského modelu soustava menších expertních modulů, z nichž se pro každý dotaz aktivuje jen relevantní podmnožina. DeepSeek prokázal, že MoE architektura může dosáhnout výkonu srovnatelného s mnohem většími hustými modely za zlomek nákladů.

Co to znamená

Škálovací zákony nebyly vyvráceny. Byly upřesněny. Říkají nám přesně to, co vždy říkaly — jen jsme je špatně četli. Mocninný zákon s exponentem 0,05 nikdy nesliboval exponenciální pokrok. Sliboval předvídatelný, ale stále pomalejší pokrok za stále větší investice.

Pro odvětví to znamená konec éry, kdy stačilo hodit na problém více GPU. Budoucí pokrok bude záviset na třech faktorech: algoritmické inovaci (nové architektury, lepší trénovací metody), efektivnějším využití inference (přemýšlení místo paměti) a lepší specializaci (správný model na správný úkol).

Pro uživatele to znamená kalibraci očekávání. Skoky typu GPT-3→GPT-4 byly anomálií, nikoliv normou. Budoucí zlepšení budou inkrementální, ale kumulativně transformativní — podobně jako pokrok v hardwaru po skončení Dennardova škálování. Procesory se nezrychlily exponenciálně, ale kombinace více jader, lepších architektur a softwarové optimalizace přinesla celkový pokrok, který uživatel vnímá jako plynulý.

Pro investory to znamená otázku: pokud zdvojnásobení compute přináší tříprocentní zlepšení, je dalších 500 miliard dolarů racionální investicí? Odpověď závisí na tom, zda algoritmická efektivita a nové paradigmata (inference scaling, MoE, agentic AI) dokáží tuto křivku posunout. Zatím ano — ale garance neexistuje.

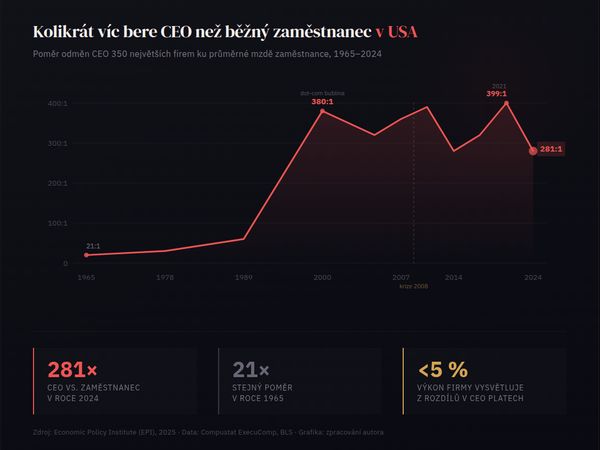

Exponenciální investice, logaritmické výnosy

V lednu 2020 stál nejdražší trénovací běh AI modelu řádově miliony dolarů. V lednu 2026 se pohybuje v miliardách. Zlepšení za tu dobu? Měřitelné, v některých oblastech dramatické, ale nikoliv proporcionální investici.

Toby Ord to shrnuje elegantně: představte si, že snížení chybovosti z deseti na pět procent stojí milion dolarů. Snížení z pěti na 2,5 procenta stojí miliardu. Z 2,5 na 1,25 procenta bilion. Každé další snížení o polovinu stojí tisícinásobek. To je podstata mocninného zákona s malým exponentem.

OpenAI věří, že nová paradigmata tento exponent zvýší. Skeptici jako Yann LeCun argumentují, že transformerová architektura má fundamentální limity a potřebujeme nový přístup. Empirická data z roku 2025 a počátku 2026 zatím nedávají jednoznačnou odpověď. GPT-5 a GPT-5.2 jsou lepší, ale ne o tolik, kolik stály. Inference-time scaling přináší novou dimenzi, ale i ta vykazuje klesající výnosy.

Co víme jistě: éra, kdy stačilo škálovat a výsledek přišel sám, je u konce. Éra, kdy je potřeba být chytřejší — ne jen větší — teprve začíná.

Tento článek navazuje na text „Moorův zákon v éře umělé inteligence“ (Médium.cz, únor 2026), který analyzuje tempo růstu AI z perspektivy vstupů (compute, algoritmy, investice). Tento text se zaměřuje na výstupy — proč exponenciální vstupy nepřinášejí exponenciální zlepšení schopností.

Klíčové zdroje: Kaplan et al. „Scaling Laws for Neural Language Models“ (arXiv:2001.08361, 2020); Hoffmann et al. „Training Compute-Optimal Large Language Models“ (Chinchilla, arXiv:2203.15556, 2022); Toby Ord „The Scaling Paradox“ (Forethought Foundation / tobyord.com, 2025); Epoch AI „Algorithmic Progress in Language Models“ (2024); Sutskever, keynote NeurIPS 2024; HEC Paris „AI Beyond the Scaling Laws“ (2026); reportáže Bloomberg, The Information, Reuters, TechCrunch (2024–2025); OpenAI GPT-5 / GPT-5.2 benchmarky a reakce (srpen–prosinec 2025).

Metodická poznámka

Koncepce, struktura a redakční linie článku jsou dílem autora, který vypracoval obsahovou skicu, stanovil klíčové teze a řídil celý proces tvorby. Generativní AI (Claude, Anthropic) byla využita jako technický nástroj pro rešerši, ověřování faktů a rozepsání autorovy předlohy.

Autor výstupy průběžně redigoval, ověřil klíčová zjištění a schválil finální znění. Žádná část textu nebyla publikována bez lidské kontroly. Všechny faktické údaje byly ověřeny proti veřejně dostupným zdrojům uvedeným v textu.

Postup je v souladu s požadavky Čl. 50 Nařízení EU 2024/1689 (AI Act) na transparentnost AI-generovaného obsahu. #poweredByAI